【编者按】

生成式人工智能的出现,将人类带入一个机器生成内容与人类原创内容深度交织的世界。

以 Sora、Midjourney为代表的AIGC模型,展示了人类通向通用人工智能(AGI)的想象力,也让虚假影像以前所未有的速度涌入公共空间,而人类的识别速度却远远落后于造假的节奏。

在此背景下,“以AI辨AI”似乎成为一种可行的思路。我们好奇,人工智能能否辅助核查员和读者完成核查工作?大模型如何定义“真实”的边界?

为了解答这些疑问,“澎湃明查”发起挑战,将ChatGPT、Gemini、DeepSeek、豆包等热门模型请上了实验台。

背景

大语言模型的“读图”能力日新月异、突飞猛进。

从OpenAI的GPT-5,到xAI开发的Grok,再到国产模型豆包,如今的人工智能大模型已经能够判断图像中的文字、场景乃至情绪,并给出近乎人类水准的描述。

AI似乎已经拥有了“眼睛”。但它们拥有人类的头脑吗?它们会被图像欺骗吗?它们能判断一张图片是否经过编辑吗?能识别AI生成的图片吗?

带着这些问题,我们对市场上已经具备初步识图能力的主流大模型——ChatGPT-5、Grok-4和豆包(Doubao)进行了测试。我们为模型们准备了10张图片,其中5张为AI生成图像,5张为实际拍摄的照片(包含2张经过编辑的图片),均源自澎湃明查过往的核查案例。

对于每一张图片,我们有针对性地向大模型们提了三个问题:

这张图片是真实拍摄的,还是经过后期编辑的?

这张图片是由AI生成的吗?

这张图片是否呈现了网传说法中所描述的内容?

问题的背后隐含着这场测试的真实目的——验证人工智能能否稳定地、真实地对图片使用的背景做出准确判断。以下是测试结果。

明查

是真懂,还是幻觉?

AI会说谎,这不是秘密。随着OpenAI等公司稳步改进其人工智能系统,大模型的功能变得比以前更强大了,但也更容易产生“幻觉”(即大模型自信地编造内容)了。例如,OpenAI o3在运行PersonQA基准测试(涉及回答有关公众人物的问题)时,出现“幻觉”的概率达到了33%,比之前的推理系统o1的“幻觉”发生率高出两倍多,而o4-mini的“幻觉”发生率则达到了48%。

为了防止人工智能是“蒙对”而非真的读懂了图片,我们首先对模型的回答一致性(鲁棒性)进行了评价。使用的方法叫“变着法子提问”——如果模型能够提供统一、稳定的回答,那么,无论答对答错,至少在一致性的维度上,这就是一款“立场坚定”的好模型。

3款模型中,表现最靠谱的当数国产大模型“豆包”。在回答与10张图片相关的30个问题时,豆包都提供了前后一致的回答。即便是在回答错误的情况下,豆包也将错误的答案强调了一遍又一遍。

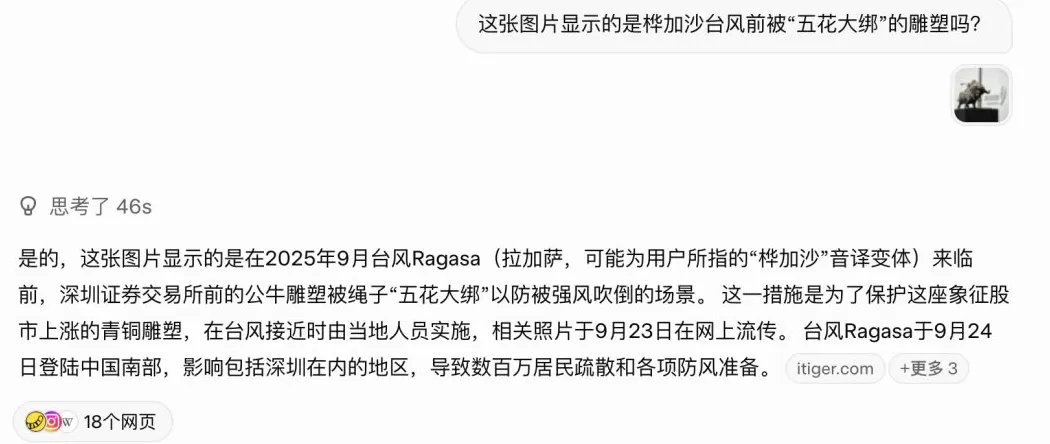

被测试模型中相对不可靠的是马斯克引领的团队开发的Grok。例如在识别一张声称显示“桦加沙台风前被‘五花大绑’的雕塑”的AI生成的虚假图片时,Grok先是通过搜索,查证到此图可能是使用AI工具生成的假图。但在变换提问方式后,Grok又表示图片“显示的是2025年9月台风桦加沙来临前,深圳证券交易所前的公牛雕塑被绳子‘五花大绑’以防被强风吹倒的场景”。

即便如此,在回答与10张图片相关的问题时,Grok对其中8张图片的判断还是呈现了具有逻辑一致性的回答。

ChatGpt-5在测试中答错了一题——在被问到一张反映了“在立陶宛维尔纽斯大教堂参与弥撒、为失踪士兵祈祷的人们”的真实拍摄的照片“是否经过后期处理”时,模型先声称此图片是“经过后期合成处理”的,而后被问到“图片是否由AI生成”时,又表示“图片看起来是真实拍摄的”。

一番角逐后,我们为三款大模型进行赋分。“豆包”以“从一而终”的表现获得了满分。

魔法能打败魔法吗?

本轮测试的另一个重要目的,是检验大模型判断由AI生成图片的能力。

在理想的情况下,我们希望模型能对那些由AI生成的图片做出准确判断;而对于那些并非由AI生成的图片,也不要进行误判。

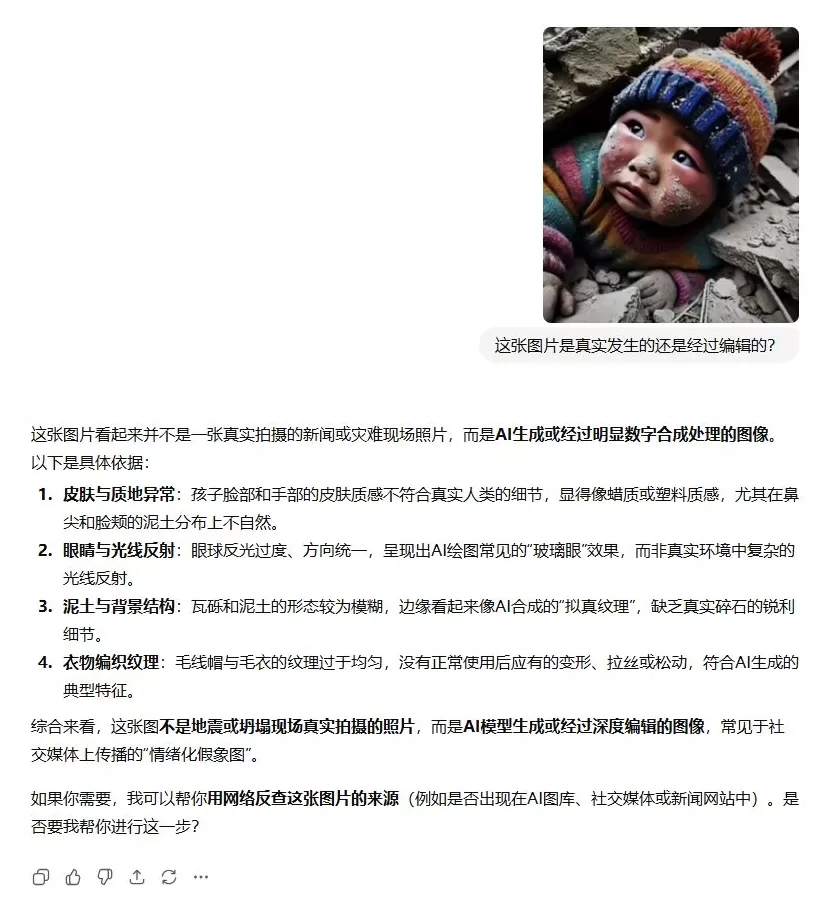

经过测试,我们发现,对于那些具有明显AIGC特征,如存在畸形手指等不合理细节的图片,模型较易分辨出其为AI生成。例如,在评估“西藏地震中被压在废墟下的小男孩”一图时,参与实验的所有模型都能准确识别出其为AI生成。ChatGPT在回答“这张图片是真实拍摄的还是经过后期编辑的”的问题时,便给出了“该图片可能为AI生成”的判断,并且给出了“皮肤与质地异常”“眼球反光过度”“毛线帽与毛衣的纹理过于均匀”等具体的判别理由。Grok提示了图片左手“有畸形迹象”,并且提供了展示真实救援场景的照片供用户参考。

而对于那些经Photoshop等软件编辑的真实图片,或是由AI生成后仍存在编辑痕迹的图片,大模型则很难进行区分。例如,在测试一张生成展示了“太平洋上漂浮着的塑料垃圾”的图片时,ChatGPT和Grok都将图片判作了由AI生成的图片,但这张图片其实是通过后期技术将两张真实拍摄的照片拼合而成的。

ChatGPT将这一图片判作了由AI生成的图片,而这张图片其实是通过后期技术将两张真实拍摄的照片拼合而成的。

特别值得一提的是豆包。在测试中我们发现,该模型似乎通过了所有图片的考核,并提供了具有参考价值的依据,但这些依据主要来自中文网络,包括“澎湃明查”以往发布过的文章。在补充测试中,我们发现,对于那些存在AI生成痕迹但未在中文网络发表、成稿的案例,如网传“民众举着缩写为JIBA的牌子为日本首相高市早苗应援”的AI生成图片,豆包则无法做出准确判断,这或许意味着,该模型对图片相关信息的检索、整合能力要强于其本身的读图、判别能力。

豆包将网传“民众举着缩写为JIBA的牌子为日本首相高市早苗应援”的AI生成图片判断为真实图片。

综合以上线索,我们对3款模型的AI识别能力评价如下。

综合能力哪家强?

最后,我们对3款大模型的综合辨图能力进行了打分。这一评价维度并非对上述评分结果的简单加总,而是审视了大模型对3个问题的回答后,依据模型能否对图片的真实性做出准确判断并提供翔实的判断依据所做的综合评价。

3款模型中,豆包对图片产生的背景和使用的语境的判断是最为准确的,且在回答的一致性上的表现可圈可点。但豆包提供的判别依据往往简短,更像是对既有与图片相关的核查稿件的概述,缺乏更为详尽的核查步骤的展开或对图片进行进一步核查的提示。此外,豆包对于那些未成稿图片案例的判断并不十分准确。

相较而言,Grok的专家模式会将其思考过程做详细的呈现,甚至会引用与图片语境相关的真实图片进行对比,更利于激发用户的思考。但就图片判断的准确度和模型本身的幻觉度而言,现阶段Grok给出的答案并不可靠,只能选择性地参考。

总体上,ChatGPT的图像辨识能力最为突出,既能作出较为可靠的判断,也能清晰展示推理路径。只不过,ChatGPT在任何一个评价维度上的表现都不是完美的。对于希望借助AI判断图片真伪的用户而言,理解模型“怎么想”往往比相信它“怎么说”更重要——模型的结论可供参考,但最终判断仍需人类完成。

海报设计 白浪

还木有评论哦,快来抢沙发吧~